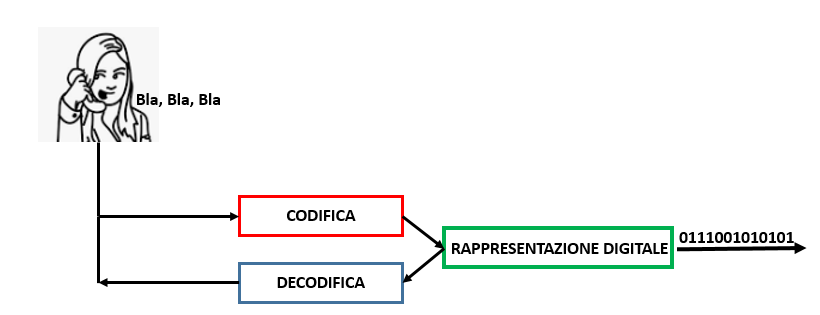

All’interno di un elaboratore le informazioni sono Codificate usando la Rappresentazione Binaria o Digitale, utilizzando un alfabeto di due soli simboli; 1 e 0.

INFORMAZIONE E CODIFICA

BIT (Binary Digit o Cifra Binaria)

L’entità minima di informazione codificabile attraverso la rappresentazione binaria è il Bit (Binary Digit o Cifra Binaria) e può assumere i valori di 1 o 0.

Con una cifra binaria si possono rappresentare solo due informazioni, che convenzionalmente corrispondono al simbolo 1 o 0, per cui se vogliamo rappresentare un numero maggiore di informazioni dovremo utilizzare più Bit, e il processo della codifica di un’informazione in una configurazione di Bit è chiamata Codifica Binaria.

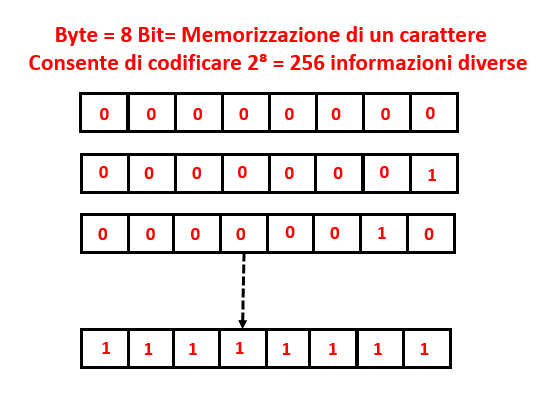

Con 1 Bit si codifica 2 informazioni : 2¹; con 2 Bit si codifica 4 informazioni: 2²; con N Bit si codificano 2ᴻ informazioni.

Es. Se devo codificare 220 informazioni si devono avere almeno 8 Bit (

2⁸ = 256).

Un gruppo di 8 Bit viene denominato Byte che è l’unità di misura della capacità di memorizzare l’informazione, e si utilizzano i multipli del Byte.

Per poter far capire al computer le informazioni elementari, come i caratteri nella comunicazione scritta, i numeri, le immagini, i video, e i suoni, è necessario utilizzare dei codici che trasformino le informazioni in un linguaggio binario.

Se ad esempio vogliamo rappresentare in caratteri l’alfabeto anglosassone, con i segni di punteggiatura, i segni matematici, i caratteri nazionale, e altri segni grafici sono necessari circa 220 caratteri, perciò, per associare a ogni carattere a una configurazione di Bit, saranno necessario 8 Bit (1 Byte).

Un codice per la codifica dei caratteri è ASCII (American Standard Code for Information Interchange, Codice Standard Americano per lo Scambio di Informazioni).

ALCUNI CODICI PER LA CODIFICA

ASCII: 7 Bit per carattere in grado di rappresentare 128 caratteri

ASCII Esteso: 8 Bit per carattere in grado di rappresentare 256 caratteri

UNICODE: 16 Bit per carattere ( ASCII + Caratteri Etnici) in grado di rappresentare 65000 caratteri

MS WINDOWS: 16 Bit per carattere (simile a UNICODE)