Il bit e il byte sono le unità di misura principali dell’informatica. Il computer lavora utilizzando un semplice sistema numerico binario ed è formato da due cifre: 0 e 1, chiamati “bit”.

Il bit è l’unità di misura dell’informazione (Binary digit), definita come la quantità minima di informazione che serve a discriminare due possibili eventi equiprobabili.

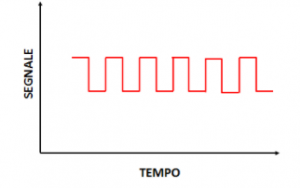

La cifra 0 indica, nei circuiti elettrici del computer, uno stato di tensione assente, mentre la cifra 1 indica uno stato di tensione presente.

Il bit preso da solo non serve a nulla ma se viene preso a gruppi (o sequenza) è in grado di inviare informazioni ai calcolatori come numeri, lettere, e simboli grafici.

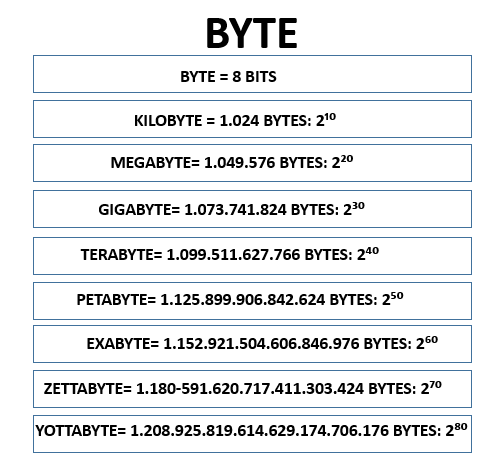

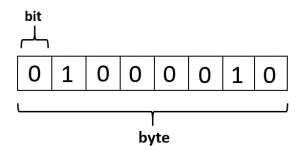

Il più noto è il byte che è formato da 8 bit. Per cui il bit e il byte permettono di “comunicare” con il computer. Per fare questo senza ricorrere al sistema binario è stato introdotto il sistema ASCII, che associa ciascun byte a uno specifico carattere alfanumerico.

Es. la “A” maiuscola corrisponde al byte: 01000001, mentre la “a” minuscola corrisponde al byte: 01100001, e così via.

I valori che possono assumere il bit sono due lo 0 e 1, mentre il byte può assumere:2⁸=256.

Riassumendo possiamo dire che il byte e i suoi multipli forniscono la misura per la dimensione dei file e anche la capacità dei dispositivi di archiviazione di massa (memoria interna al PC, chiavetta USB, micro SD, ecc.).

Il bit e i suoi multipli sono usati per esprimere la quantità di dati trasmessi (Kilobit per sec.=Kbps; Megabit per sec.=Mbps, ecc.).

Per convertire il bit in byte e viceversa, tenendo conto che 1B=8 bit, si fa in questo modo: per passare da byte al bit si moltiplica per 8; se si deve passare da bit al byte si deve dividere per 8.

Es. 10 byte sono 80 bit; 80 bit sono 10 byte.